Следующее поколение платформы Blackwell от Nvidia появится в Google Cloud в начале 2025 года

На этой неделе в Лас-Вегасе проходит Google Cloud Next, что означает, что пришло время для ряда новых типов экземпляров и ускорителей на платформе Google Cloud. Помимо новых настраиваемых чипов на основе Arm Axion, большинство анонсов этого года связаны с ускорителями искусственного интеллекта, будь то от Google или от Nvidia.

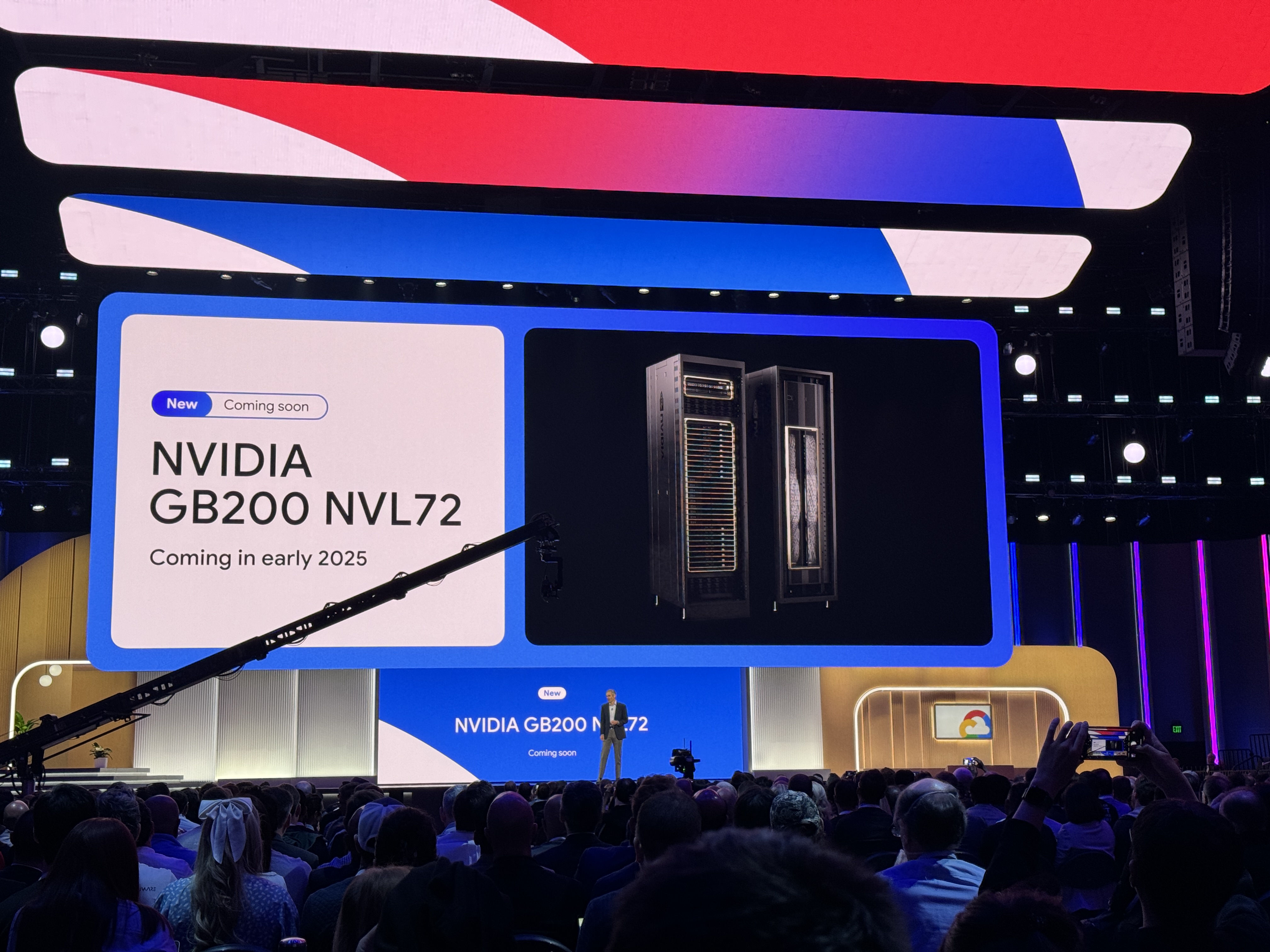

Только несколько недель назад Nvidia объявила о своей платформе Blackwell. Но не ожидайте, что Google предложит эти машины в ближайшее время. Поддержка высокопроизводительного Nvidia HGX B200 для задач искусственного интеллекта и вычислений HPC, а также GB200 NBL72 для обучения больших языковых моделей (LLM) появится в начале 2025 года. Один интересный момент из объявления Google: серверы GB200 будут жидкостно охлаждаться.

Это может показаться немного преждевременным объявлением, но Nvidia заявила, что ее чипы Blackwell не будут доступны для общего пользования до последнего квартала этого года.

Перед Blackwell

Для разработчиков, которым сегодня нужна большая мощность для обучения LLM, Google также объявил об инстансе A3 Mega. Этот инстанс, разработанный компанией вместе с Nvidia, оснащен стандартными для отрасли GPU H100, но сочетает их с новой сетевой системой, способной обеспечить до удвоения пропускной способности на GPU.

Еще одним новым инстансом A3 является A3 confidential, который Google описывает как позволяющий клиентам "лучше защищать конфиденциальность и целостность чувствительных данных и рабочих нагрузок искусственного интеллекта во время обучения и вывода." Компания давно предлагает услуги конфиденциального вычисления, которые шифруют данные во время использования, и здесь, после включения, конфиденциальное вычисление будет шифровать передачу данных между процессором Intel и GPU Nvidia H100 через защищенный PCIe. Не требуются изменения кода, говорит Google.

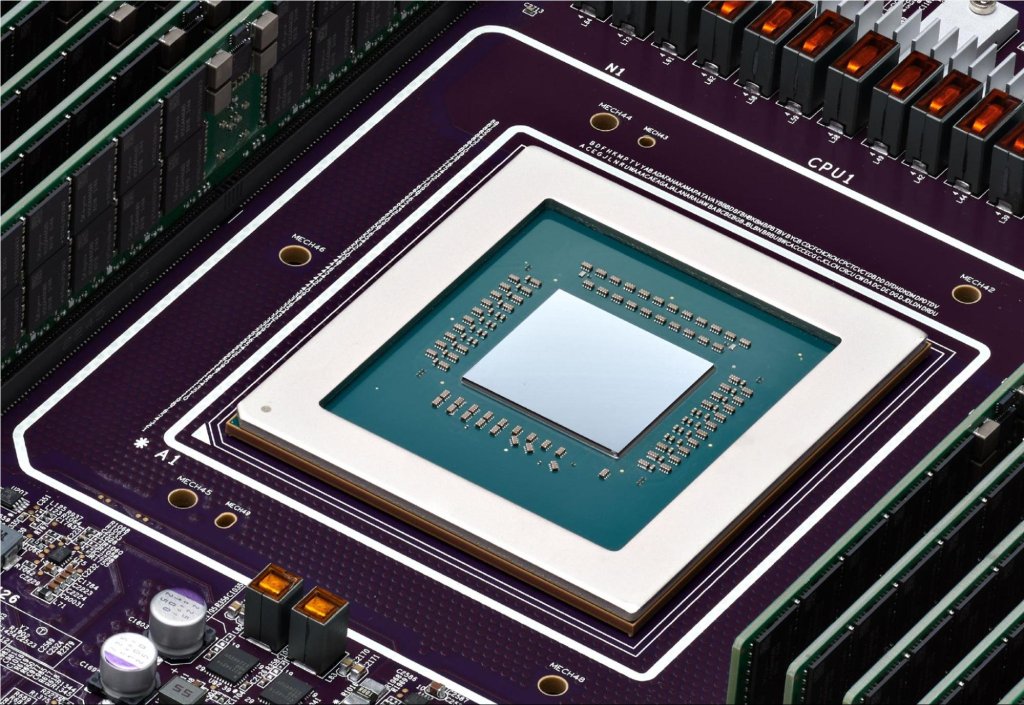

Что касается собственных чипов Google, во вторник компания запустила в общее использование свои процессоры Cloud TPU v5p - самые мощные из ее собственных ускорителей искусственного интеллекта на сегодняшний день. Эти чипы обладают увеличением в 2 раза операций с плавающей запятой в секунду и увеличением в 3 раза скорости пропускания памяти.

Все эти быстрые чипы требуют базовой архитектуры, которая способна их сопровождать. Поэтому наряду с новыми чипами Google также объявила новые варианты хранения, оптимизированные для искусственного интеллекта. Hyperdisk ML, который сейчас находится в режиме предварительного просмотра, является новейшим блочным сервисом хранения компании, который, по словам Google, может улучшить время загрузки модели вплоть до 3,7 раза.

Google Cloud также запускает ряд более традиционных инстансов, работающих на процессорах четвертого и пятого поколений Xeon от Intel. Например, новые универсальные инстансы C4 и N4 будут оснащены пятого поколения процессорами Emerald Rapids Xeons, при этом C4 сосредоточены на производительности, а N4 - на цене. Новые инстансы C4 сейчас находятся в частном предварительном доступе, и машины N4 доступны в настоящее время.

Также новыми, но все еще находящимися в предварительном доступе, являются машины C3 bare-metal, работающие на старых процессорах четвертого поколения Intel Xeons, X4 memory-optimized bare metal инстансы (также находящиеся в предварительном доступе) и Z3, первая оптимизированная для хранения виртуальная машина Google Cloud, обещающая предложить "наивысшее количество операций ввода-вывода для оптимизированных для хранения инстансов среди ведущих облачных платформ".

Доклад Nvidia на GTC принес несколько сюрпризов